Die Display-Technologien entwickeln sich stets weiter und vor einigen Jahren sind die Hersteller von Monitoren und insbesondere TV-Geräten dazu übergegangen, High Dynamic Range – kurz: HDR – in die Bildschirme zu integrieren.

Allerdings teilt sich der Markt auf in diverse unterschiedliche Standards, die den Kauf eines passenden Gerätes erschweren. Welcher HDR-Standard für welche Features steht und was sich hinter der Technologie überhaupt verbirgt, zeigt dieser Artikel.

HDR – Zweck der HDR-Technologie

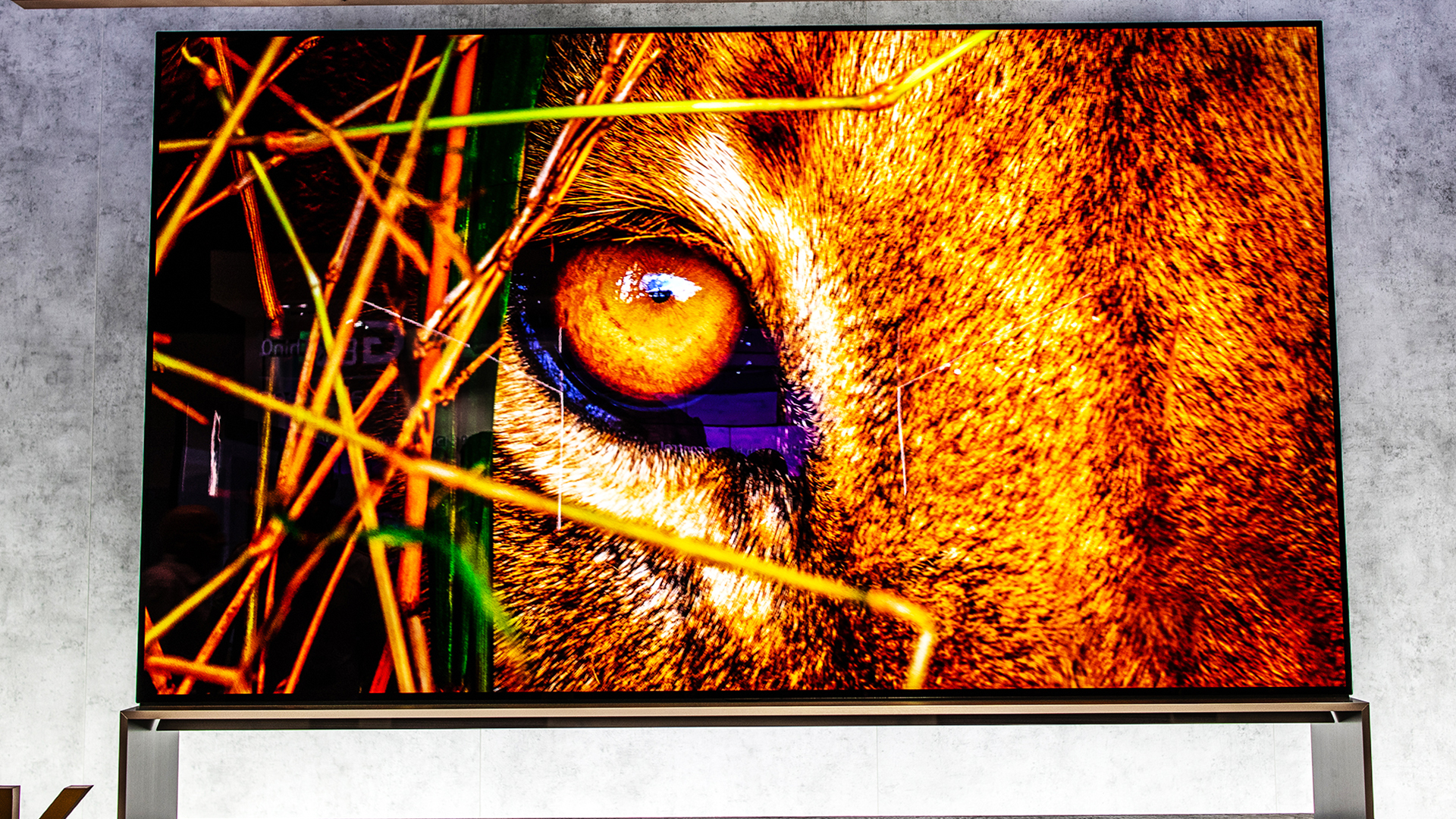

Bilder auf einem TV-Gerät können sich nicht mit der Realität messen. Befindest du dich nachts in absoluter Dunkelheit, werden sich deine Augen nach kurzer Zeit daran gewöhnen und Details sowie auch einige Farben zeigen.

Schaust du am Tag hingegen direkt in die Sonne – nicht, dass wir dies empfehlen würden –, wirst du so derart geblendet, dass du sofort die Augen abwenden musst.

Diesen extrem hohen Dynamikumfang können TV-Geräte unter normalen Umständen nicht abbilden. Die Aufnahme eines Sonnenaufgangs in einer Dokumentation blendet dich nicht und Bilder bei absoluter Dunkelheit zeigen praktisch gar keine Details.

Der mangelhafte Dynamikumfang verbreiteter, „ordinärer“ Displays bedeutet, dass der Helligkeitsbereich zwischen dem dunkelsten und dem hellsten Bereich eines Bildes durch HDR wesentlich vergrößert werden kann.

Es wird also möglich, beispielsweise eine Naturaufnahme zu zeigen, in der eine helle Sonne am Himmel steht und du die grell beleuchteten Wolken genau erkennen kannst, aber gleichzeitig die Details im Schatten eines Baumes ebenfalls gut sehen kannst.

Das Resultat sind natürlichere und, gelegentlich, sogar „über-natürliche“ Bilder, die du so in der Realität niemals zu Gesicht bekommen würdest. Hier liegt es an den Herstellern der Geräte und den Bereitstellern der Inhalte, die richtige Balance zu finden.

HDR in Zahlen

Um ein tieferes Verständnis für den Zugewinn an Bildqualität zu entwickeln, helfen einige Zahlen.

Schauen wir uns zuerst das menschliche Auge an: Wenn wir von einem Sonnenuntergang ausgehen, ist der direkte Blick in das Sonnenlicht an einem Sommertag ungefähr eine Million Mal heller – oder 10^6.

Umgekehrt ist der Himmel bei Nacht und Neumond in Bezug auf die Helligkeit ungefähr eine Million Mal dunkler, also 10^-6. Auf einer Skala dieser Art beträgt der Dynamikumfang des menschlichen Auges somit 10^12 – vom hellsten bis zum dunkelsten wahrnehmbaren Punkt.

Typische Fernseher ohne HDR schaffen es, einen Dynamikbereich von etwa 10^3 abzubilden. Das ist der menschlichen Wahrnehmung offensichtlich weit unterlegen. HDR-Fernseher erhöhen diesen Bereich allerdings auf 10^5 und verfügen somit schon über einen um das Hundertfache angestiegenen Dynamikbereich.

Typische Fernseher ohne HDR schaffen es, einen Dynamikbereich von etwa 10^3 abzubilden. Das ist der menschlichen Wahrnehmung offensichtlich weit unterlegen. HDR-Fernseher erhöhen diesen Bereich allerdings auf 10^5 und verfügen somit schon über einen um das Hundertfache angestiegenen Dynamikbereich.

Zwar ist das noch immer weit von unserem Auge entfernt, aber doch schon bedeutend näher an der Realität als es mit handelsüblichen, normalen Fernsehern oder Monitoren der Fall ist. Licht und Schatten entsprechen eher dem, was wir im Alltag zu Gesicht bekommen.

Auswirkungen auf die Farben – HDR

Bislang sprachen wir hauptsächlich von Licht und Dunkelheit. Ein Nebeneffekt dieses erhöhten Dynamikbereiches betrifft aber auch die Farbwiedergabe: Durch die feineren Abstufungen lassen sich Farbtöne besser (sprich: realer) darstellen. Das wird vor allem in sehr dynamischen Bildern mit viel Licht, Schatten und unterschiedlichen Farben deutlich.

Stelle dir eine Szene vor, die in einem spärlich beleuchteten Raum spielt. Draußen ist es Tag und vor dem Fenster wachsen einige Rosen in kräftigem Rot. Es ist unwahrscheinlich, dass dieses Rot tatsächlich sichtbar wäre, da die Dunkelheit des Raumes nicht genügend Farbabstufungen für die in hellem Tageslicht stehenden Rosen übrig lässt.

Auf einem HDR-Fernseher siehst du somit nicht nur helleres Hell und dunkleres Dunkel, sondern auch intensivere Farben. Vor allem in Spielen auf Konsolen, die für HDR optimiert wurden, wird der Unterschied schnell deutlich. Populäre Beispiele auf Xbox One oder PlayStation 4 sind etwa Forza Horizon 4 oder Horizon: Zero Dawn, die im HDR-Modus deutlich an Bildqualität gewinnen.

Das liegt an der Farbtiefe: 8 Bit, wie sie gewöhnliche Fernseher darstellen, bieten 256 Farbabstufungen (2^8) pro Farbe. Bei 10 Bit, wie es in HDR10 der Fall ist, wächst die Anzahl auf 1.024 Farbstufungen (2^10).

Dolby Vision bringt es bereits auf 12 Bit, womit pro Farbe 4.096 Abstufungen möglich sind (2^12). Vor allem sanfte Farbverläufe, wie etwa ein Sonnenuntergang, profitieren davon deutlich, da weniger Color-Banding auftaucht.

Das generelle HDR-Problem: die Inhalte

HDR ist eine derjenigen Technologien, die leider nicht „einfach so“ funktionieren. Die Inhalte – Filme, Serien, Spiele – müssen schon während des Erstellungsprozesses mit HDR kompatibel gemacht werden.

Ist das nicht der Fall, sehen Inhalte auf einem HDR-Fernseher nicht besser oder schlechter aus als an einem ganz gewöhnlichen SDR-Gerät.

Bevor du jetzt einen Aufpreis bezahlst, nur um einen guten HDR-Fernseher zu kaufen, solltenst du dich also vergewissern, dass du auch entsprechende Inhalte schauen wirst. Das typische Fernsehprogramm etwa profitiert von HDR noch gar nicht (mit einer kleinen Ausnahme namens HLG, dazu später mehr).

Unter anderem die folgenden Inhalte sind mit HDR kompatibel und erhöhen die Bildqualität bisweilen beträchtlich:

HDR in Games

Microsoft und Sony bieten für Xbox One und PlayStation 4 (und auch die kommenden Xbox Series X und PlayStation 5) bestimmte Spiele an, die für HDR optimiert sind.

In der Regel handelt es sich dabei um prestigeträchtige AAA-Titel, die dieser Behandlung unterzogen werden und auf einem Fernseher dann ein kleines Farbenfeuerwerk veranstalten. Als Spieler solltest du den HDR-Standard ernsthaft in Erwägung ziehen.

Streaming-Angebote in HDR

Amazon (Prime Video), Netflix & Co. sind schon immer recht flott dabei, wenn es um die Umstellung auf neue Technologien geht.

So findest du bei allen namhaften Streaminganbietern auch Inhalte in HDR – Dokumentationen, selbstproduzierte Serien und auch Filme. In der Regel kennzeichnen die Anbieter diese Programme auch werbewirksam schön deutlich.

High Dynamic Range in Filmen

Vereinzelt findest du Filme, die HDR-Aufnahmen anbieten. Damit es sich für die Filmstudios rechnet, sind das meistens recht große Produktionen, die viel Geld zurück in die Kassen schaufeln. Die Auswahl ist daher, im Vergleich zum Streaming, noch immer recht begrenzt – wie es überhaupt bei Ultra-HD-BDs der Fall ist.

Mit anderen Worten: Wenn du danach suchst, findest du in jedem Medium passende HDR-Inhalte. Wir würden pauschal festhalten, dass der Kauf für Spieler inzwischen immer eine sehr gute Idee ist.

Zahlreiche Spiele profitieren davon in sehr hohem Maße. Bist du Film- und Serienfan, solltest du schauen, ob die zu dir passenden Inhalte jetzt schon von HDR profitieren oder nicht.

HDR-Fernseher sind HDR-kompatibel – oder?

Ein Problem von HDR-Fernsehern war gerade zu Beginn die Tatsache, dass Kompatibilität allein noch nicht ausreicht.

Sprich: Technisch gesehen konnte es passieren, dass die Hersteller alle technischen Voraussetzungen für HDR-Kompatibilität in ihre Geräte einbauen und dann das HDR-Logo auf ihre Fernseher kleben durften.

Es war für diese HDR-Fernseher allerdings keine Voraussetzung, die dafür notwendige maximale Helligkeit auch erreichen zu können.

Um HDR wirklich in vollem Umfang genießen zu können, sollten Displays mindestens über eine Leuchtstärke von 1.000 Candela verfügen.

Displays mit einem geringeren Wert können technisch womöglich alle Voraussetzungen für die Anzeige von HDR-Inhalten erfüllen – nur würdest du davon weniger mitbekommen, weil die maximale Leuchtstärke nicht ausreicht, um den hohen Dynamikumfang vollständig zu präsentieren.

Wie bereits erwähnt, trat dieser Makel vorrangig am Anfang der HDR-Technologie in Fernsehern auf. Bisweilen wurden sogar 8-Bit-Panels verbaut, die völlig ungeeignet sind. Modernere Standards haben dabei geholfen, diesem für den Konsumenten äußerst unfreundlichen Umgang mit dem HDR-Label einen Riegel vorzuschieben – und genau diese Standards schauen wir uns nun an.

Die unterschiedlichen HDR-Standards im Überblick

Dem Zuschauer stellt sich das Problem in den Weg, dass es nicht „das eine HDR“ am Fernseher oder PC-Monitor gibt. Zahlreiche unterschiedliche Standards erschweren die Auswahl und führen dazu, dass du als Kunde recht viel Recherche aufwenden musst, um eine für dich passende Auswahl freffen zu können.

Um jene Recherche ein wenig zu erleichtern, werfen wir nun einen Blick auf vier verbreitete Standards und ihre eigenen Vor- und Nachteile.

Was ist der HDR10-Standard?

Vorweg: Die Hersteller verwenden HDR und HDR10 oft synonym. Falls du an einem TV-Gerät also einen Aufkleber findest, auf dem nur HDR steht, ist damit aller Wahrscheinlichkeit nach HDR10 gemeint. Zur Sicherheit solltest du dich trotzdem erkundigen, wie genau der HDR-Standard bei diesem Gerät umgesetzt wird.

HDR10 bekommt seinen Namen daher, dass eine Farbtiefe von 10 Bit für den Aufbau der Bilder bereitsteht. Normale SDR-Geräte hingegen setzen auf nur 8 Bit. Dieser Unterschied mag gering klingen, in der Realität ist damit allerdings ein Dynamikumfang von 64:1 (8-Bit-Farbtiefe) gegen 200.000:1 (10-Bit-Farbtiefe) gemeint.

An einem HDR10-Gerät wirst du also, entsprechende Inhalte vorausgesetzt, wesentlich dynamischere Farben und Helligkeitsabstufungen sehen.

Ein Makel von HDR10 besteht in den Metadaten: Diese werden zusammen mit dem Bildsignal übertragen und beinhalten etwa Informationen über die Gammakurve, die für die Bildausgabe zuständig ist.

Darin ist festgeschrieben, wie die unterschiedlichen Helligkeitswerte der Bilder auf einem Monitor auszusehen haben. HDR10 überträgt allerdings nur eine einzige Gammakurve für den gesamten Film, sodass diese Metadaten am Ende eher statisch als dynamisch sind.

Helle Szenen könnten also noch ein wenig heller sein, dunkle Szenen entsprechend dunkler und durch die Bank weg könnten Details noch besser sichtbar sein – und genau an diesem Punkt setzt HDR10+ an.

HDR10+ / HDR+

HDR10+, auch unter HDR+ bekannt, wurde fast im Alleingang von Samsung entwickelt und behebt den Fehler von HDR10. Metadaten mit darin enthaltenen Gammakurven sind dynamischer Natur und sorgen dafür, dass der Ersteller des Inhaltes im Voraus für jede Szene eigene Helligkeits-, Kontrast- oder Schwarzwerte einstellen kann.

In HDR10 würden diese Werte immer statisch gelten – für eine Szene, die in fast vollständiger Dunkelheit spielt, würden also trotzdem Einstellungen übernommen werden, die eigentlich für mit Licht geflutete Außenszenen genutzt werden. Dies geht zu Lasten der Bildqualität.

Wer sich die Mühe machen möchte, kann sogar für jedes Einzelbild fertiger Filme einzelne Einstellungen angeben. Das würde zwar in der Realität niemand erwägen, aber es verdeutlicht den großen technischen Vorsprung im Vergleich zu HDR10.

Von dieser Tatsache abgesehen unterscheidet sich HDR10+ aber nicht von HDR10. Wenn du mit deinem HDR10-Gerät bereits zufrieden bist, spricht also nichts für einen Neukauf, nur um auf HDR10+ umzusteigen.

Handelt es sich bei deinen ersten TV-Kauf um ein Gerät mit HDR-Feature, solltest du aber allein schon aufgrund der Zukunftssicherheit auf das HDR10+-Label achten.

Denn: Samsung hat den Standard quelloffen gehalten, es steht anderen Herstellern also frei, ihn zu übernehmen. Neben Samsung selbst bieten bereits einige Firmen wie Panasonic, Philips oder Hisense entsprechende Geräte an.

Dolby Vision

Die aktuelle Speerspitze der HDR-Technologie ist ebenso technisch beeindruckend wie von einigen Probleme geplagt. Dolby Vision erhöht die Farbtiefe auf 12 Bit – wohlgemerkt gibt es aktuell noch kein einziges Display, das eine solche Farbtiefe darstellen kann.

Die dynamischen Metadaten, die auch HDR10+ bietet, sind hier ebenfalls mit an Bord. In der Praxis führt das dazu, dass ungefähr 4.000 unterschiedliche Helligkeitsstufen pro Szene dargestellt werden können. HDR10 schafft „nur“ 1.000 Stufen.

Auch die gesamte Helligkeit des Displays kann deutlich erhöht werden. HDR10 kann mit maximal 4.000 Nits umgehen. Eine typische Ultra-HD-Blu-ray wird aktuell mit guten 1.000 Nits gemastert – schon HDR10 bietet also viel Luft nach oben.

Dolby Vision erhöht dies gleich auf maximal 10.000 Nits und ist somit auch in dieser Kategorie weit überlegen. Außerdem kann der Standard mit 8K-Inhalten mit bis zu 120 fps umgehen. Zusätzlich verspricht Dolby, dass nur Geräte, die einen optimalen Abgleich von TV-Gerät und BD-Player gewährleisten, dieses Logo tragen dürfen.

Mit anderen Worten: Technisch gesehen ist Dolby Vision eine ganz andere Hausnummer. Gleichzeitig steht aber zu bedenken, dass es aktuell noch keinen Fernseher gibt (und auch in einigen Jahren noch nicht geben wird), der die technischen Möglichkeiten dieses Standards auch nur im Ansatz ausreizt.

Entscheidest du dich für einen Fernseher mit Dolby Vision, tätigest du also vor allem eine Investition für die Zukunft – die sich aber auch jetzt schon für dich auszahlen kann.

Denn: Unterstützt ein Fernseher Dolby Vision, ist er automatisch auch für HDR10 zertifiziert. HDR10+ hingegen ist davon noch ausgenommen – aber da heißt es ohnehin, dass abzuwarten bleibt, wie viele Hersteller auf den HDR10+-Zug aufspringen.

In der Regel solltest du mit einem Dolby-Vision-Fernseher im Moment jedenfalls keinen Fehler machen.

HLG – Hybrid Log Gamma

HLG ist eine Art interessanter Kompromiss: Er wurde vorrangig für Fernsehsender entwickelt. Diese leiden generell unter dem Problem, dass die vorhandenen Kapazitäten für die Übertragung via Satelliten oder Kabel begrenzt sind. Jene Kapazitäten sind ohnehin permanent ausgereizt, Luft nach oben besteht also nicht.

Falls Fernsehsender nun Übertragungen in HD ausstrahlen und dabei sowohl eine SDR- als auch HDR-Version ihrer Inhalte unter die Zuschauer bringen müssen, würde das die effektiv benötigte Bandbreite praktisch verdoppeln.

Das verursacht zuerst Kosten für die Sender und dann auch Kosten für alle anderen an der Infrastruktur beteiligten Parteien. Am Ende liefe es wohl darauf hinaus, dass natürlich nicht die Sender die Kosten tragen würden, sondern: die Konsumenten.

Hybrid Log Gamma, oder HLG, ist ein Versuch, diesem Problem entgegenzusteuern. Es wird nur ein einziger Videostream gesendet, der keine zusätzlichen Metadaten für Helligkeit und Kontrast erhält, sondern die zum SDR-Inhalt passende Gammakurve einfach mit ein wenig zusätzlichen Kontrast erweitert.

Das Resultat kann nicht ganz mit HDR10 mithalten, aber es kommt schon recht nah dran. Für Fernsehsender ist dies mittelfristig die einzige Möglichkeit, HDR über Kabel oder Satellit auszusenden, ohne dabei eine Kostenexplosion zu erfahren.

Bislang ist das Angebot aber begrenzt. Hier und da laufen einige Programme, die HLG-kompatibel sind – etwa Der Bergdoktor beim ZDF. Bis eine weite Verbreitung gegeben ist, wird aber noch viel Zeit vergehen.

Wie stelle ich eine HDR-Kompatibilität sicher?

Zuletzt möchten wir noch kurz darauf hinweisen, dass HDR kein Selbstläufer ist. Alle Elemente in der Kette müssen für HDR zertifiziert sein, damit du von den Inhalten profitierst.

Bei einem Setup zu Hause währen das beispielsweise eine HDR-fähige Blu-ray-Disc, ein Abspielgerät, das mit HDR etwas anfangen kann und der HDR-fähige Fernseher – und auch das Kabel muss HDR-fähig sein, also mindestens HDMI 2.0 und eine Bandbreite von 18 Gbit/s unterstützen.

Vor allem auf diese Bandbreite solltest du achten, da es auch HDMI-2.0-Kabel gibt, die nur 10,2 Gbit/s unterstützen und so kein HDR mit 60 Hz anzeigen können.

Abschließender Blick: HDR auf PC-Monitoren

Vorrangig haben wir uns mit TV-Geräten beschäftigt. Auch PC-Monitore bieten seit längerer Zeit HDR-kompatible Modelle an, dort musst du ebenfalls zwischen HDR10, Dolby Vision & Co. abwägen.

Es gelten dieselben Vor- und Nachteile wie beim Fernseher: Inhalte müssen extra zugeschnitten werden, das typische YouTube-Video wird also nicht verbessert. Spieler profitieren mitunter deutlich – und müssen auch keine hohen Hardware-Kosten fürchten.

Die Einflüsse auf die Performance sind minimal und bewegen sich im Rahmen weniger Prozentpunkte.

Die Ursache dafür ist in der Tatsache zu finden, dass Grafikkarten das Bild intern ohnehin mit einer höheren Farbtiefe berechnen, sodass der letztendliche Output in 10 Bit anstelle von 8 Bit fast gar keine Auswirkungen hat.